2024年5月,跃昉科技正式加入“甲辰计划”,旨在与各生态伙伴合作,致力于在下一个丙辰年(2036龙年)之前,基于RISC-V架构实现从数据中心到桌面办公、从移动穿戴到智能物联网全信息产业覆盖的开放标准体系及开源系统软件栈,使RISC-V软硬件生态达到作为主流指令集架构所需的生态成熟度。

近日,跃昉科技宣布了一项重大技术突破:Transformer、Gradio等PyTorch生态核心大语言模型(LLM)软件栈,已在RISC-V高性能平台上成功完成移植及适配验证。这一里程碑式的成就标志着RISC-V架构在AI和大语言模型领域的应用上迈出了重要一步。

Transformer是一种深度学习模型框架,最早由 Vaswani 等人在 2017 年提出,专门用于处理序列数据(如自然语言、时间序列等)的任务。Transformer 通过引入自注意力机制(Self-Attention Mechanism) 来捕捉序列中不同位置之间的依赖关系,并通过并行处理大大提高了训练效率。

RISC-V计算架构以其简洁、开放、灵活、低功耗、模块化及可扩展性等特点,正逐步成为AI时代的原生计算架构。作为RISC-V架构SoC芯片设计与产业应用的开拓者,跃昉科技专注于研发基于RISC-V的高端芯片及配套软件栈核心技术,不断探索其在高性能计算领域的潜力。

在此次与开源社区的合作中,跃昉团队深入钻研,攻克了多个技术难题,确保了Transformer等LLM软件栈在RISC-V高性能平台上流畅运行,降低了LLM软件栈对特定硬件的依赖,为其带来了更加多元化的运行环境选择,提高了系统的灵活性和可扩展性。

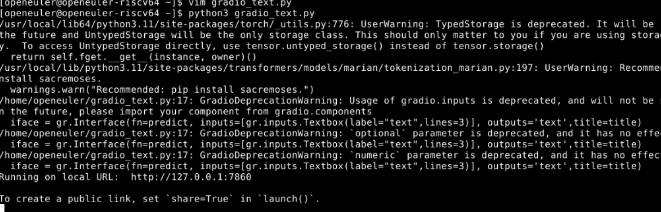

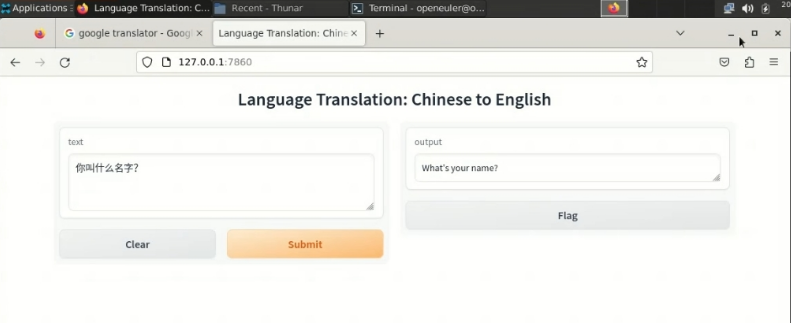

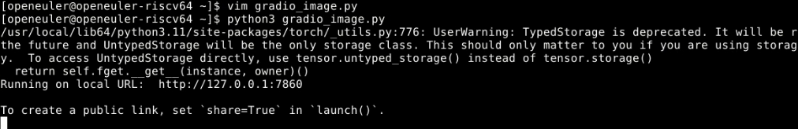

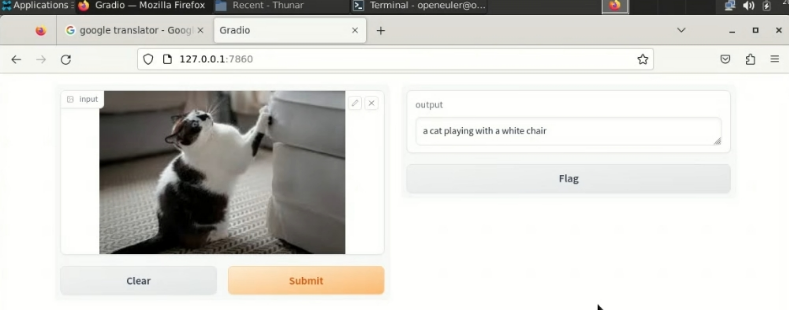

移植案例展示 1 创建LLM应用-中英文翻译的访问链接 2 使用RISC-V CPU执行LLM应用-中英文翻译 3 创建LLM应用-图生文的访问链接 4 使用RISC-V CPU执行LLM应用-图生文

移植案例中,中英文翻译和图生文等LLM应用在RISC-V高性能平台上的顺利实施,充分展示了RISC-V在AI领域的应用潜力,进一步完善了RISC-V高性能软件栈。 未来,跃昉科技将继续携手各生态伙伴,助力RISC-V高性能软件生态建设,拓展RISC-V的高性能应用场景,共同推动RISC-V生态系统的发展,为全球用户带来更多创新高效的产品和解决方案!